Prozessanalyse verwandelt Ist-Abläufe in messbare Soll-Prozesse. Dieser Leitfaden zeigt Methoden, Datenquellen und Tools, um Schwachstellen zu erkennen. Effekt.

Begriffe klären: Ist, Soll und die Lücke dazwischen

Ist-Prozess beschreibt, wie heute tatsächlich gearbeitet wird – mit allen Varianten, Wartezeiten und Workarounds. Soll-Prozess ist das angestrebte Zielbild, optimiert auf Kundennutzen, Qualität und Effizienz. Die Gap-Analyse quantifiziert die Abweichung zwischen Ist und Soll (z. B. Lead Time, First-Time-Right, Rework-Quote) und liefert die Roadmap für Maßnahmen. Abgrenzung: Prozessmodellierung dokumentiert Abläufe (z. B. BPMN), Prozessoptimierung verbessert sie – die Prozessanalyse ist die evidenzbasierte Brücke.

Methoden der Prozessanalyse im Überblick

- SIPOC: Grenzen, Inputs, Outputs und Kunden klären – ideal zum Projektstart und Scoping.

- Value Stream Mapping: Zeit, Wertschöpfung und Verschwendung sichtbar machen; perfekt für Durchlaufzeiten und NVA-Anteile.

- EPK/BPMN-Modellierung: Varianten und Regeln strukturiert erfassen; gute Basis für Governance und Schulung.

- Gemba Walk: Dorthin gehen, wo Wert entsteht. Realität schlägt Meeting-Meinung.

- Interviews & Workshops: Kontext, Regeln, Ausnahmen; bitte mit Leitfaden, sonst dominiert die lauteste Stimme.

- Shadowing: Tätigkeiten „über die Schulter“ begleiten – nützlich bei wissensintensiven Aufgaben.

- Dokumentenreview: Richtlinien, SLAs, SOPs vs. gelebte Praxis.

Auswahlkriterium: Zielbild (Kosten, Qualität, Zeit), Datenlage und Reifegrad. Tipp: klein anfangen, schnell lernen, skalieren.

Datengetrieben: Process Mining & Task Mining

Process Mining nutzt Event-Logs aus ERP/CRM/MES, rekonstruiert Varianten, identifiziert Bottlenecks und Rework. Über Conformance Checking wird der gelebte Prozess gegen das Soll-Modell geprüft – Abweichungen (z. B. Skip, Rework, Reorder) werden messbar. Automation-Potenziale springen ins Auge: stabile Regeln + hohes Volumen = RPA/Workflow-Kandidat.

Task Mining ergänzt die Desktop-Ebene: Klickpfade, Formularzeiten, Copy-Paste-Orgien. Vorsicht Datenschutz: nur mit klarer Einwilligung, Pseudonymisierung und Zweckbindung.

Qualitativ trifft quantitativ: Mixed-Methods clever kombinieren

Trick 1: Triangulation – Daten (Mining), Beobachtung (Gemba/Shadowing) und Stakeholder-Insights (Interviews) zusammenführen.

Trick 2: Hypothesenbildung – „Lange Durchlaufzeit wegen Freigabeschleife?“

Trick 3: Verifizierung – Logdaten und Stichproben checken.

Trick 4: Priorisierung – Aufwand/Nutzen und Risikowirkung bewerten. Ergebnis: ein belastbarer Maßnahmenkatalog statt Bauchgefühl.

Nutzen & Einsatzpotenziale

- Transparenz über Wege, Wartezeiten, Nacharbeiten

- Kosten- und Zeitreduktion durch Eliminierung von NVA

- Compliance & Auditfähigkeit via Conformance-Reports

- Customer Experience: weniger Medienbrüche, schnellere Reaktionszeiten

- Automatisierung: RPA/Workflow dort, wo Regeln stabil sind

- Standardisierung & Skalierung: Best Practices im ganzen Unternehmen

Herausforderungen und was wirklich hilft

- Unklare Ziele → Klarer Scope mit messbaren KPIs (z. B. -20 % Lead Time).

- Interview-Bias → Sampling, Leitfäden, Faktenchecks gegen Logs.

- Tool-Overkill → Pragmatisch starten (SIPOC + Mining + Gemba reicht oft).

- Datenqualität → Data Readiness Check: Events, Zeitstempel, Case-IDs, Vollständigkeit.

- Silodenken → Governance & Rollen: Process Owner, Data Steward, Sponsor.

Praxisbeispiele & Trends

- Quick Wins: Durchlaufzeit-Heatmaps zeigen Freigabestaus in Minuten.

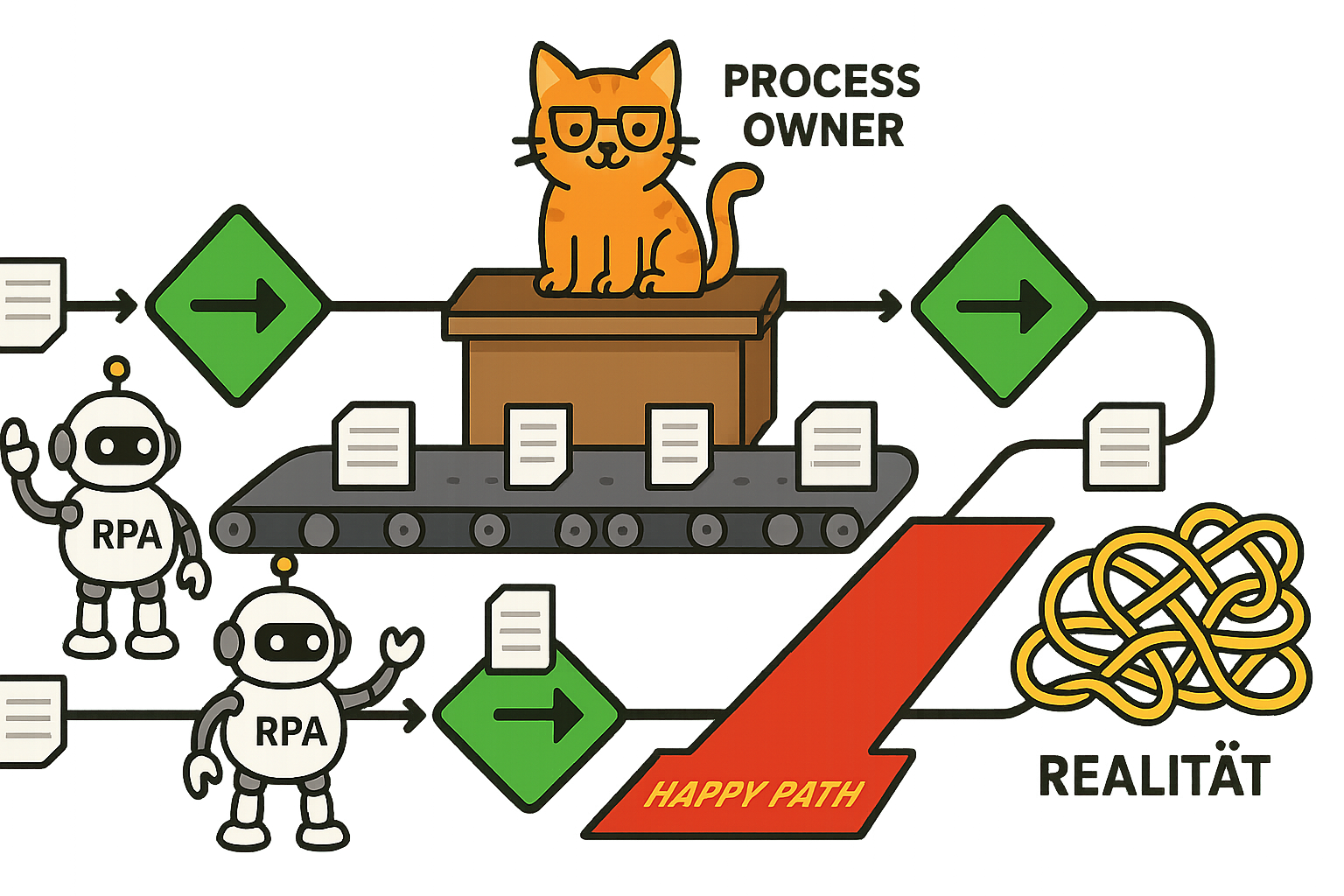

- „Happy Path vs. Realität“: 15 % Fälle folgen dem Modell, der Rest liebt Abkürzungen.

- KI-gestützte Variantenerkennung: Muster in langen End-to-End-Prozessen.

- Generative Doku-Erstellung: Aus Logs + Modellen entstehen Draft-SOPs.

- Kontinuierliches Monitoring: Dashboards als Frühwarnsystem statt „Jahres-MRI“.

Vom Befund zum Zielbild: Soll-Prozesse gestalten

Designprinzipien:

- Kundennutzen zuerst (z. B. „Time to Resolution“).

- Simplicity: weniger Übergaben, klare Regeln, „Stop Doing“-Liste.

- Automatisierbarkeit: strukturierte Daten, eindeutige Entscheidungen.

Definieren Sie Schnittstellen, Rollen, KPIs und Kontrollen. Dann: Proof of Concept, Pilot, kontrolliertes Roll-out – und Notausstieg formulieren, falls Annahmen nicht halten.

Umsetzung planen: Maßnahmen, KPIs, Business Case

- Backlog & Roadmap: Epics (z. B. „Freigaben vereinfachen“), Sprints, Owner.

- Aufwand/Nutzen-Matrix: Low Effort/High Impact zuerst.

- KPI-Set: Lead Time, FTR (First-Time-Right), NVA-Anteil, Durchsatz, Konformitätsrate.

- Change-Plan: Schulungen, Playbooks, Enablement-Sessions.

- Risk & Control Mapping: SoD, Vier-Augen-Prinzip, Kontrollpunkte im Flow.

- Compliance-Checks: Datenschutz, Regulatorik, interne Policies.

Leitfaden für den Start im eigenen Unternehmen

- Pilotprozess + Zielmetrik wählen (z. B. -30 % Bearbeitungszeit).

- Methodenset festlegen: SIPOC fürs Scope, Mining für Fakten, Interviews für Kontext.

- Datengrundlage sichern: Event-Logs, IDs, Zeitstempel, Datenschutz.

- Stakeholder-Map & RACI: wer entscheidet, wer arbeitet, wer informiert wird.

- Tooling pragmatisch: erst funktional, dann „nice to have“.

- Kommunikationsplan: Warum, Was, Wie – samt Quick-Win-Showcase.

- Reviews & Retros: monatlich Wirkung messen, Hypothesen nachschärfen.

Fazit

Prozessanalyse ist kein Selbstzweck, sondern der verlässliche Pfad vom Ist zum Soll. Wer Daten, Beobachtung und Menschen kombiniert, deckt echte Ursachen auf, priorisiert wirksam – und schafft die Basis für Automatisierung, Compliance und messbar bessere Kundenerlebnisse. Kurz: erst verstehen, dann verändern, dann skalieren.

Key Facts

- Prozessanalyse schließt die Lücke vom Ist zum Soll mit klaren KPIs.

- Kombination aus Mining, Modellierung und Gemba liefert robuste Befunde.

- Sauberes Scope, Datenqualität und Governance verhindern Analyseläufe ins Leere.

Schreibe einen Kommentar