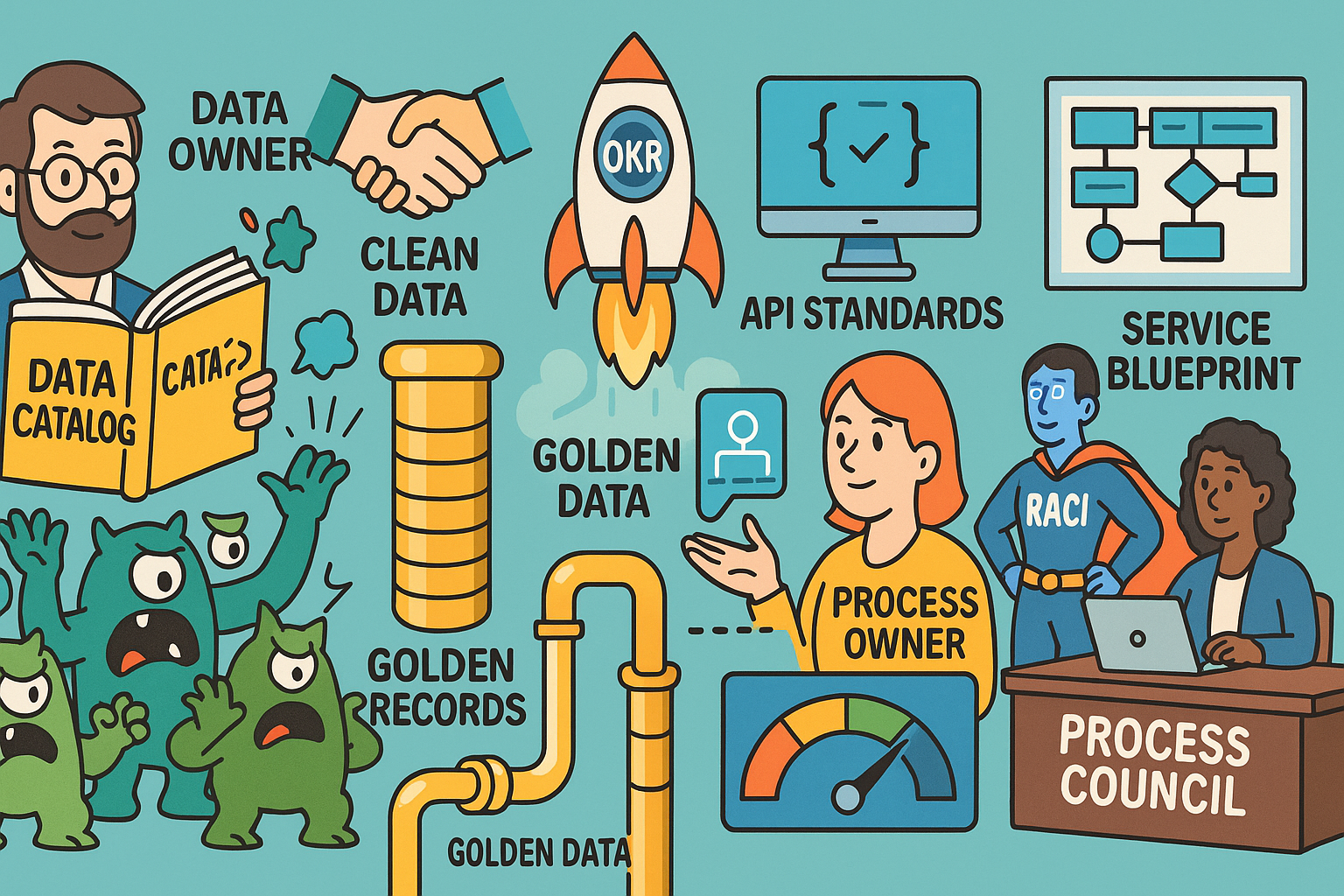

Wer digital transformieren will, braucht zwei starke Arme: Data Governance für verlässliche Informationen und strategisches Prozessmanagement für zielgerichtete Abläufe. Zusammen besiegen sie Wettbewerbsdruck, heben Effizienzpotenziale und halten die Kundenzentrierung hoch. Kurz geklärt:

- Data Governance: Regeln, Rollen und Standards für den Umgang mit Daten.

- Datenqualität: Korrektheit, Vollständigkeit, Aktualität, Konsistenz.

- Datenverantwortung: Klar definierte Verantwortliche für Daten(-objekte).

- Prozessarchitektur: Struktur der Prozesslandschaft inkl. Abhängigkeiten.

- End-to-End-Prozess: Von Kundenimpuls bis Wertversprechen – ohne Silogräben.

Was bedeutet Data Governance im Prozesskontext?

Data Governance wird wirksam, wenn sie im Prozess lebt:

- Rollen: Data Owner (geschäftliche Verantwortung), Data Stewards (operatives Qualitätsmanagement), Custodians (technische Bereitstellung).

- Policies & Standards: Namenskonventionen, Validierungsregeln, Zugriffsrichtlinien, Aufbewahrungsfristen.

- Datenlebenszyklus: Erfassung → Pflege → Nutzung → Archivierung → Löschung – mit messbaren Qualitätskriterien je Phase.

- Metadaten & Kataloge: „Was bedeutet Feld X?“ ist kein Rätselraten, sondern im Data Catalog dokumentiert – inklusive Lineage bis zum Report.

- Verbindung zu Prozessen: Qualitätsregeln werden zu Kontrollpunkten in Prozessmodellen; KPIs (z. B. First-Time-Right) verknüpfen Datenqualität mit Prozessergebnis.

Strategisches Prozessmanagement: Vom Zielbild zur Steuerung

Strategie braucht einen Laufzettel:

- Prozesslandkarte & Wertstromsicht zeigen, welche End-to-End-Flows den größten Kundennutzen erzeugen.

- OKR-/KPI-Kaskade: Von Unternehmenszielen zu Prozesszielen (z. B. „Auftragsdurchlaufzeit ≤ 24 h“).

- Rollen & Gremien: Process Owner, Process Architect und ein Process Council priorisieren, standardisieren und lösen Zielkonflikte.

- Reifegradmodelle (z. B. CMMI-ähnlich): Wo stehen wir? Was fehlt zur nächsten Stufe?

- Kontinuierliche Verbesserung: Hypothesen, Experimente, Retros – gern mit Process Mining als Faktenbasis.

Gemeinsamer Werthebel: Datenqualität als Prozess-Outcome

Saubere Stamm-, Referenz- und Ereignisdaten sind wie gut geölte Rollen auf dem Prozessfließband:

- Durchlaufzeiten sinken, weil weniger Nachfragen und Korrekturen anfallen.

- First-Time-Right steigt, weil Validierungen früh greifen.

- Kundenerlebnis verbessert sich, weil Informationen konsistent über Kanäle hinweg sind.

Wichtig: Bidirektionalität. Gute Prozesse erzwingen gute Daten (Pflichtfelder, Prüfungen), und gute Daten ermöglichen bessere Prozesse (Automatisierung, Routing, Personalisierung).

Nutzen und Einsatzpotenziale

- Compliance-Sicherheit: Auditierbare Datenflüsse, nachvollziehbare Lineage, klare Verantwortlichkeiten – Prüfer*innen lieben es.

- Automatisierung: Robuste Datenmodelle machen RPA/Workflow/Low-Code belastbar statt brüchig.

- Bessere Entscheidungen: Verlässliche KPI-Cockpits statt Excel-Zoologie.

- Skalierbarkeit: Standardisierte Daten- und Prozessbausteine lassen sich domänenübergreifend wiederverwenden.

Herausforderungen und Lösungsansätze

Technisch: Tool-Sprawl, brüchige Schnittstellen, uneinheitliche Semantik.

Lösung: Datenmodell-Guidelines, API-Standards (Versionierung, Idempotenz, Ereignisschemata) und eine semantische Schicht mit gemeinsamem Glossar.

Organisatorisch: Silos, unklare Ownership, Priorisierungsroulette.

Lösung: Saubere RACI, ein gemeinsames Data & Process Council und Produkt-/Domänenteams mit einem (!) priorisierten Backlog.

Kulturell: Datenpflege-Verdrossenheit („Macht die IT schon“).

Lösung: Anreize über KPIs, Data Literacy Trainings, und Shift Left: Qualitätsprüfungen früh in den Prozess, nicht am Ende.

Praxisbeispiele und Trends

- Data Contracts zwischen Domänen: Vereinbaren Struktur, Qualität und SLAs für Ereignisse und APIs – stabilisieren damit Automationsflüsse.

- Process- & Task Mining: Liefert objektive Varianten, Bottlenecks und Compliance-Abweichungen; Rückkopplung in Governance-Regeln.

- KI-gestützte Datenqualität: Mustererkennung, Auto-Korrekturvorschläge, NLP-Checks für Freitexte; Generative KI beschleunigt Dokumentation & Mapping.

- Data Mesh: Dezentrale Domänenverantwortung, aber mit Guardrails – perfekt für prozessnahe Datenprodukte.

- Service-Blueprints: Verknüpfen Frontstage-Schritte mit Backstage-Datenpunkten; Gaps werden sichtbar wie ein Neon-Post-it.

Leitfaden für die Einführung in der eigenen Praxis

- Ziele & Wertströme priorisieren: Wo entsteht der größte Hebel (Kundenerlebnis, Risiko, OPEX)?

- Operating Model definieren: Rollen, Rituale, Artefakte für Data Governance und Prozessmanagement – abgestimmt, nicht parallel.

- Datenkontrollpunkte verankern: In Prozess-Blueprints an kritischen Schritten (Erfassung, Entscheidung, Übergabe).

- KPI-Design koppeln: Qualitäts-, Prozess- und Risikoindikatoren logisch verbinden (z. B. FTF-Quote → Rework → Durchlaufzeit).

- Golden Records sichern: Stammdatenprozesse stabilisieren, Dublettenmanagement, Referenzdatenpflege.

- Data Catalog & Glossar einführen: Auffindbarkeit, Lineage, Verantwortlichkeiten – Self-Service statt Flurfunk.

- Pilot wählen: Klare Hypothesen, messbare Ziel-KPIs, Timebox; danach Domänen-weise skalieren.

- Change & Enablement: Trainings für Data Literacy, Guardrails für Citizen Dev, regelmäßige Review-Zyklen mit Council-Abnahme.

Messung & Steuerung

- Leading KPIs: Datenvollständigkeit bei Erfassung, Validierungsfehlerquote, Automatisierungsgrad.

- Lagging KPIs: NPS, Churn, Cost-to-Serve, Audit-Findings.

- Regelmäßige OKR-Check-ins und Scorecards halten Fokus und machen Fortschritt sichtbar – Ampel statt Bauchgefühl.

Key Facts

- Data Governance und Prozessmanagement verstärken sich gegenseitig.

- Datenqualität ist ein zentraler Hebel für Effizienz und Compliance.

- Klare Ownership und ein gemeinsames Operating Model sind entscheidend.

- Mining, Data Contracts und KI beschleunigen transparente Skalierung.

Fazit

Wenn Data Governance die Wahrheit sichert und strategisches Prozessmanagement den Weg dorthin plant, entsteht ein kompaktes Betriebssystem für Skalierung, Compliance und Kundennutzen. Das Ergebnis: weniger Nacharbeit, mehr First-Time-Right, saubere Automatisierung – und Cockpits, die Entscheidungen ermöglichen statt Diskussionen über Zahlenherkunft. Oder, humorvoll gesagt: Daten sind das Benzin, Prozesse das Getriebe – gemeinsam fährt Ihr Unternehmen nicht nur, es beschleunigt kontrolliert.

Schreibe einen Kommentar